Big Data là gì? Ứng dụng của Big Data

Công nghệ Big Data đã đạt đến đỉnh cao trong việc thực hiện vượt trội các chức năng và ứng dụng của nó. Bài viết dưới đây giúp bạn có thể nhận biết về chức năng, quy trình, sử dụng và tầm quan trọng của công nghệ Big Data.

Big Data là gì?

Big Data là các tập dữ liệu có khối lượng lớn và phức tạp. Độ lớn đến mức các phần mềm xử lý dữ liệu truyền thống không có khả năng thu thập, quản lý và xử lý dữ liệu trong một khoảng thời gian hợp lý.

Những tập dữ liệu lớn này có thể bao gồm các dữ liệu có cấu trúc, không có cấu trúc và bán cấu trúc, mỗi tập có thể được khai thác để tìm hiểu insights.

Các giải pháp Big Data cung cấp các công cụ, phương pháp và công nghệ được sử dụng để nắm bắt, lưu trữ, tìm kiếm và phân tích dữ liệu trong vài giây để tìm mối quan hệ và hiểu biết về cải tiến và lợi ích cạnh tranh mà trước đây không có.

Big Data là các tập dữ liệu có khối lượng lớn và phức tạp

Ngày nay, 80% dữ liệu là dữ liệu không có cấu trúc và không thể được xử lý bởi các công nghệ truyền thống. Trước đó, một lượng dữ liệu được tạo ra không cao. Chúng ta tiếp tục lưu trữ dữ liệu vì chỉ cần phân tích lịch sử dữ liệu. Nhưng ngày nay việc tạo dữ liệu tính bằng petabyte và không thể lưu trữ dữ liệu nhiều lần và lấy lại khi cần.

Ứng dụng của Big Data

Dưới đây là một số ứng dụng trong mỗi chuyên môn khác nhau:

- Netflix sử dụng Big Data để cải thiện trải nghiệm của khách hàng

- Phân tích chiến dịch và kế hoạch xúc tiến của Sears Holding

- Phân tích cảm xúc

- Phân tích khách hàng

- Phân tích dự đoán

- Kết hợp và quảng cáo theo thời gian thực

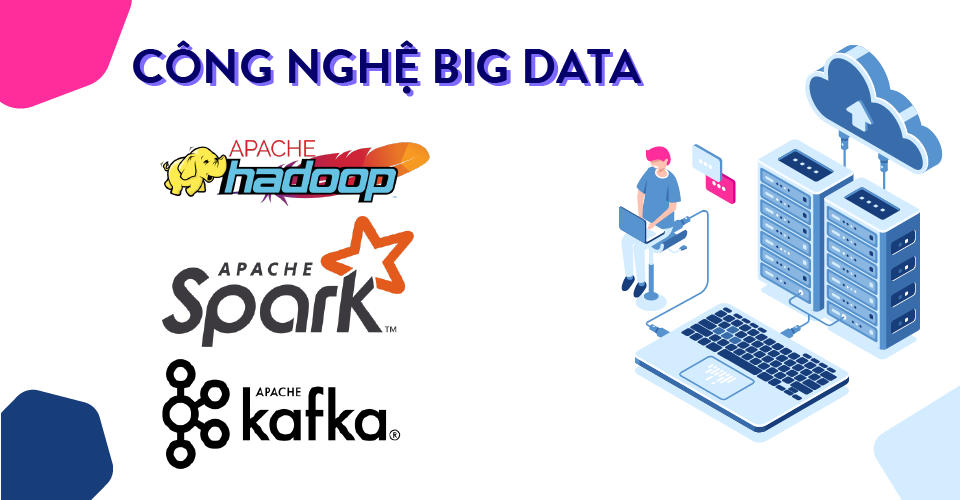

Công nghệ Big Data

Có rất nhiều công nghệ để giải quyết vấn đề lưu trữ và xử lý Big Data. Những công nghệ đó là Apache Hadoop, Apache Spark, Apache Kafka, v.v … Dưới đây là thông tin tổng quan về các công nghệ này.

Có rất nhiều công nghệ để giải quyết vấn đề lưu trữ và xử lý Big Data

- Apache Hadoop

Hadoop là một Apache framework mã nguồn mở được viết bằng Java, cho phép xử lý phân tán (distributed processing) các tập dữ liệu lớn trên các cụm máy tính (clusters of computers) thông qua mô hình lập trình đơn giản. Hadoop được thiết kế để mở rộng quy mô từ một máy chủ đơn sang hàng ngàn máy tính khác có tính toán và lưu trữ cục bộ (local computation and storage).

- Apache Spark

Sự cải tiến hơn nữa của công nghệ này đã dẫn đến sự phát triển của Apache Spark – công cụ tính toán nhanh và có mục đích chung để xử lý quy mô lớn. Nó có thể xử lý dữ liệu nhanh hơn 100 lần so với MapReduce.

- Apache Kafka

Apache Kafka là một bổ sung khác cho hệ sinh thái Big Data, một hệ thống nhắn tin phân tán lượng thông tin cao thường được sử dụng với Hadoop.

Các tổ chức công nghệ thông tin đã bắt đầu xem xét sáng kiến Big Data để quản lý dữ liệu của họ theo cách tốt hơn, trực quan hóa dữ liệu, hiểu rõ hơn về dữ liệu này khi được yêu cầu và tìm cơ hội kinh doanh mới để thúc đẩy tăng trưởng kinh doanh.

Mọi CIO đều muốn chuyển đổi công ty của mình, nâng cao mô hình kinh doanh và xác định các nguồn doanh thu tiềm năng trong bất kỳ lĩnh vực nào ví dụ như lĩnh vực viễn thông, lĩnh vực ngân hàng, bán lẻ hoặc chăm sóc sức khỏe, v.v … Chuyển đổi kinh doanh như vậy đòi hỏi phải có công cụ phù hợp và thuê đúng người để đảm bảo hiểu biết đúng insights, đúng thời điểm từ dữ liệu có sẵn.

Tóm lại, Big Data là thách thức đặt ra cho các tổ chức, doanh nghiệp trong thời đại số hiện nay. Một khi làm chủ được Big Data thì họ sẽ có cơ hội thành công lớn hơn trong bối cảnh cạnh tranh ngày nay. Thế giới thì sẽ được hưởng lợi hơn từ việc trích xuất thông tin một cách chính xác hơn, hữu ích hơn với chi phí thấp hơn.

Tuy vẫn còn những chỉ trích về Big Data nhưng đây là một lĩnh vực còn rất mới nên sẽ tiếp tục phát triển và cải tiến trong tương lai.

- Xem thêm: Khác biệt giữa Data Science và Ai

Nguồn: Data-flair.training